İçerik

- Büyük Veri Yapılandırılmamış veya Yarı Yapısaldır

- İşleyemezsek Büyük Veriyi Saklamanın Hiçbir Noktası Yok

- Hadoop Büyük Veri Sorununu Nasıl Çözüyor?

- Hadoop İçin İş Davası

Paket servisi:

Hadoop bazı büyük verilerin büyük zorlukların çözülmesine yardımcı olabilir.

Büyük veri ... iyi ... büyük boyutlu! Tam olarak ne kadar verinin büyük veriler olarak sınıflandırılabildiği kesin olarak kesin değil, bu yüzden bu tartışmada tıkanmayacak. Gigabayttaki verilerle uğraşmak için kullanılan küçük bir şirket için 10 TB veri BÜYÜK olacaktır. Ancak Yahoo gibi şirketler için petabaytlar büyüktür.Sadece büyük veri boyutu, veritabanları veya geleneksel dosyalayıcılar gibi geleneksel depolarda saklanmasını imkansız kılar (veya en azından maliyeti düşük tutar). Gigabayt veri saklama maliyetinden bahsediyoruz. Geleneksel depolama dolgularını kullanmak, büyük verileri saklamak için çok paraya mal olabilir.

Burada büyük verilere, zorluklara ve Hadoop'un bunları çözmede nasıl yardımcı olabileceğine bir göz atın.İlk olarak, büyük veriler en büyük zorluklar.

Büyük Veri Yapılandırılmamış veya Yarı Yapısaldır

Birçok büyük veri yapılandırılmamış. Örneğin, tıklama günlüğü verileri şuna benzeyebilir:zaman damgası, user_id, sayfa, referrer_page

Yapı eksikliği, ilişkisel veritabanlarını büyük verileri depolamak için uygun değildir. Ayrıca, pek çok veritabanı milyarlarca veri satırını depolamakla başa çıkamaz.

İşleyemezsek Büyük Veriyi Saklamanın Hiçbir Noktası Yok

Büyük verilerin saklanması oyunun bir parçasıdır. Bunun dışında istihbarat madeni için onu işlemeliyiz. Geleneksel depolama sistemleri, yalnızca bit depolamak anlamında oldukça "aptal". Herhangi bir işlem gücü sunmuyorlar.Geleneksel veri işleme modeli, işlenmek üzere bir hesaplama kümesine kopyalanan bir depolama kümesinde depolanan verilere sahiptir. Sonuçlar depolama kümesine geri yazılır.

Bununla birlikte, bu model büyük miktarda veri için işe yaramıyor çünkü bir hesaplama kümesine çok fazla veri kopyalamak çok zaman alabilir veya imkansız olabilir. Peki cevap nedir?

Çözümlerden biri, büyük kümeleri bir hesaplama kümesi olarak iki katına çıkaran bir depolama kümesinde olduğu gibi işlemek.

Yukarıda gördüğümüz gibi, büyük veriler geleneksel depolamaya meydan okuyor. Peki büyük verileri nasıl ele alıyoruz?

Hadoop Büyük Veri Sorununu Nasıl Çözüyor?

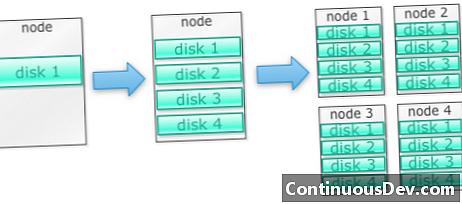

Hadoop bir dizi makinede çalışacak şekilde üretilmiştirBir örnekle başlayalım. Diyelim ki çok fazla fotoğraf saklamamız gerekiyor. Tek bir diskle başlayacağız. Tek bir diski aştığımızda, makineye yığılmış birkaç disk kullanabiliriz. Tek bir makinedeki tüm diskleri genişlettiğimizde, her biri bir sürü disk içeren bir makine almamız gerekir.

Bu tam olarak Hadoop'un nasıl yapıldığı. Hadoop başından beri bir makine kümesi üzerinde çalışacak şekilde tasarlanmıştır.

Hadoop kümeleri yatay olarak ölçeklenir

Bir Hadoop kümesine daha fazla düğüm eklenerek daha fazla depolama ve bilgi işlem gücü elde edilebilir. Bu, daha güçlü ve pahalı donanım satın alma ihtiyacını ortadan kaldırır.

Hadoop yapılandırılmamış / yarı yapılandırılmış verileri yönetebilir

Hadoop sakladığı veriler üzerinde bir şema uygulamıyor. İsteğe bağlı ve ikili verileri işleyebilir. Böylece Hadoop yapılandırılmamış verileri kolayca sindirebilir.

Hadoop kümeleri depolama ve bilgi işlem sağlar

Ayrı depolama ve işleme kümelerine sahip olmanın büyük veriler için en uygun yöntem olmadığını gördük. Ancak Hadoop kümeleri, hepsi bir arada depolama ve dağıtılmış bilgi işlem sağlar.

Hadoop İçin İş Davası

Hadoop büyük veri için uygun maliyetle depolama sağlar

Geleneksel verileri kullanarak büyük verileri saklamak pahalı olabilir. Hadoop emtia donanımları etrafında inşa edilmiştir, bu yüzden makul bir maliyetle oldukça büyük depolama sağlayabilir. Hadoop Petabyte ölçeğinde sahada kullanılmıştır.

Cloudera'nın bir çalışması, işletmelerin genellikle terabayt başına yılda yaklaşık 25.000 ila 50.000 dolar harcadığını öne sürdü. Hadoop ile bu maliyet yılda terabayt başına birkaç bin dolara düşüyor. Donanım daha ucuz ve daha ucuz hale geldikçe, bu maliyet düşmeye devam ediyor.

Hadoop yeni veya daha fazla veri yakalamaya izin verir

Bazen kuruluşlar bir tür veri yakalayamazlar çünkü saklamak için maliyeti düşüktü. Hadoop makul bir maliyette depolama sağladığından, bu tür veriler yakalanabilir ve saklanabilir.

Bir örnek, web sitesi tıklama günlükleri olabilir. Bu kütüklerin hacmi çok yüksek olabileceğinden, çoğu kurum bunları ele geçirmedi. Şimdi Hadoop ile günlükleri yakalamak ve saklamak mümkündür.

Hadoop ile verileri daha uzun süre saklayabilirsiniz

Depolanan verilerin hacmini yönetmek için şirketler periyodik olarak eski verileri temizler. Örneğin, yalnızca son üç aydaki günlükler saklanırken eski günlükler silindi. Hadoop ile tarihsel verileri daha uzun süre saklamak mümkündür. Bu, eski analitik verilerin eski geçmiş veriler üzerinde yapılmasına izin verir.

Örneğin, bir web sitesinden tıklama günlüklerini alın. Birkaç yıl önce, bu günlükler, popüler sayfalar gibi istatistikleri hesaplamak için kısa bir süre boyunca saklandı. Şimdi Hadoop ile, bu tıklama günlüklerini daha uzun süre depolamak uygun olur.

Hadoop ölçeklenebilir analitik sağlar

Eğer analiz edemezsek, bütün bu verileri saklamanın bir anlamı yoktur. Hadoop yalnızca dağıtılmış depolama sağlamakla kalmaz, aynı zamanda dağıtılmış işleme de sağlar; bu, büyük miktarda veriyi paralel olarak dağıtabileceğimiz anlamına gelir. Hadoop'un hesaplama çerçevesine MapReduce adı verilir. MapReduce'un petabayt ölçeğinde olduğu kanıtlanmıştır.

Hadoop zengin analitik sağlar

Yerel MapReduce, birincil programlama dili olarak Java'yı desteklemektedir. Ruby, Python ve R gibi diğer diller de kullanılabilir.

Elbette, özel MapReduce kodunu yazmak, Hadoop'ta verileri analiz etmenin tek yolu değildir. Üst düzey Harita Küçültme kullanılabilir. Örneğin, Pig adında bir araç İngilizceyi veri akışı dili gibi alır ve bunları MapReduce'a çevirir. Başka bir araç olan Hive, SQL sorgularını alır ve MapReduce kullanarak çalıştırır.

İş zekası (BI) araçları daha da yüksek düzeyde analiz sağlayabilir. Bu tür analiz için de araçlar var.

Bu içerik, Mark Kerzner ve Sujee Maniyam tarafından "Hadoop Illuminated" dan alınmıştır. Creative Commons Atıf-Ticari Olmayan-ShareAlike 3.0 Unported License aracılığıyla sağlanmıştır.